No es ninguna novedad que Instagram es una de las redes sociales más usadas por jóvenes y menores. No lo es para las familias y al parecer, tampoco para quienes pretenden aprovecharse de ellos: según un informe elaborado recientemente por la Universidad de Stanford y Massachusetts, y del que se ha hecho eco el Wall Street Journal, solo en esta red social existen al menos entre 500 y 1.000 cuentas que funcionan a modo de "mercado negro" de contenido pornográfico de menores.

Accede aquí al estudio completo.

Estos canales y grupos, a través de los grupos y chats de Instagram y los hastaghs o etiquetas, estarían viéndose además reforzados por el algoritmo de la aplicación, recomendando las cuentas a otros pedófilos.

"Debido al uso generalizado de hashtags, a la vida relativamente larga de las cuentas de los vendedores y, sobre todo, al eficaz algoritmo de recomendación, Instagram sirve como mecanismo de descubrimiento clave para esta comunidad específica de compradores y vendedores", explican el estudio.

¿Cómo se ha descubierto? Acceder a contenidos pornográficos a través de esta y otras redes sociales como TikTok no es difícil. Y en el caso del porno de menores en Instagram parece ser que tampoco presenta muchos problemas.

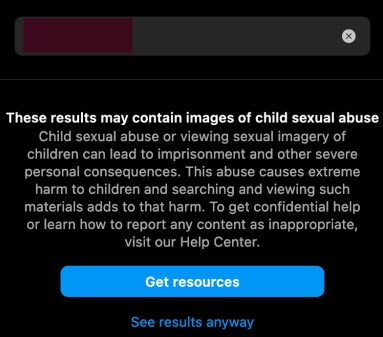

Según relata el informe, cuando se buscan términos relativos a estos contenidos, aparece un texto de advertencia "preciso y potencialmente útil" que, "sin embargo, presenta un botón para `ver los resultados de todos modos´". El sistema de recomendación de sugerencias de usuarios de Instagram tambiénpromueve fácilmente otras cuentas a los usuarios que ven una cuenta en la red, permitiendo el descubrimiento de cuentas sin búsquedas de palabras clave.

"Estos resultados podrían contener imagenes de abuso sexual infantil": Un aviso "potencialmente útil"... sin mucha utilidad: "Ver los resultados de todas formas" está al alcance de un click.

Crear una cuenta, buscar... y las recomendaciones llegan

Acceder a estos contenidos ha sido, por desgracia, sencillo: los mismos investigadores han creado una cuenta desde cero y accedido al contenido compartido por esas cuentas. Acto seguido, la misma aplicación recomendó otras cuentas similares a las que seguir.

Las únicas barreras presentes no son tanto de la aplicación en sí como de las propias cuentas que ocultan su actividad de venta de material sexual ilícito a través de un lenguaje codificado e imágenes como emoticonos o los citados hastaghs.

También publican "menús" de contenido en lugar de publicarlo abiertamente, invitando a los compradores a encargar actos específicos relacionados con parafilias y menores. Encontraron por ejemplo, que algunas cuentas ofrecen a niños para encuentros en persona "en función del precio".

Lo sorprendente, relataron los investigadores, es que al denunciar estas cuentas a través de las herramientas de la aplicación, estas eran ignoradas o descartadas de forma frecuente.

En declaraciones para The Wall Street Journal, Meta ha reconocido los problemas en sus operaciones de cumplimiento y asegura haber establecido un grupo de trabajo interno para abordar los problemas relacionados con la explotación infantil.

Confirman haber eliminado "múltiples" redes de pedófilos (en realidad, 27 redes de distribución en los dos últimos años) y bloqueado miles de hashtags que sexualizan a los niños, y añaden que están trabajando para evitar que sus sistemas recomienden adultos potencialmente pedófilos para conectarse entre sí o interactuar con el contenido del otro.

Sem comentários:

Enviar um comentário